对于绝大多数站点而言,Robots.txt都是一个极为重要的文件。它能够控制各种搜索引擎爬虫对站点的检索,并最终影响站点页面的收录。在SEO中,robots文件的管理也是一个专门的话题。在本文中,主机之旅(Hostingjourney.com)简要给大家介绍一下两个问题:WordPress站点如何检查robots.txt文件是否存在或缺失?典型通用的robots.txt内容该怎么写?

Robots.txt是个文本文件,它位于网站的根目录,所以要检查该文件是否存在,方法很简单。你只需直接访问:www.yourdomain.com/robots.txt(注意:yourdomain.com需要替换成你的域名),如果可以访问,并有内容显示,就说明该文件是存在的。

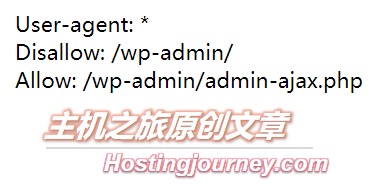

对于一个WordPress站点,通常的,也是最简单的robots.txt文件内容只需包括三行指令,见下图:

在上图中,各行代码的含义如下:

user-agent:*

它的意思是指本页指令适用于所有的搜索引擎爬虫。

Disallow: /wp-admin/

上面这样的意思是禁止搜索引擎爬虫访问根目录下的wp-admin目录。

Allow: /wp-admin/admin-ajax.php

图例中robots.txt文件的最后一行,意思是:允许爬虫读取/wp-admin/admin-ajax.php文件。